全部 Python+大数据新闻动态 Python+大数据技术文章 Python+大数据学习常见问题 技术问答

-

-

Scrapy框架的运行流程详解

Scrapy的运作流程由引擎控制,其过程如下:(1)引擎向Spiders请求第个要爬取的URL(s)。(2)引擎从Spiders中获取到第一个要爬取的URL,封装成Request并交给调度器。(3)引擎向调度器请求下一个要爬取的Request。 查看全文>>

Python+大数据技术文章2021-06-09 |传智教育 |Scrapy框架的运行

-

NumPy常用的数据类型有哪些?怎样进行转换?

NumPy支持比Python更多的数据类型。下面介绍一些常用的数据类型,以及这些数据类型之间的转换。通过“ndarray.dtype”可以创建一个表示数据类型的对象。要想获取数据类型的名称,则需要访问name属性进行获取,示例代码如下。 查看全文>>

Python+大数据技术文章2021-06-09 |传智教育 |NumPy中常用的数据类型

-

如何通过Anaconda管理Python包?

Anaconda集成了常用的扩展包,能够方便地对这些扩展包进行管理,比如安装和卸载包,这些操作都需要依赖conda。conda是一个在Windows、Mac OS和Linux上运行的开源软件包管理系统和环境管理系统,可以快速地安装、运行和更新软件包及其依赖项。 查看全文>>

Python+大数据技术文章2021-06-09 |传智教育 |Anaconda,Anaconda管理Python包

-

Python如何连连接MongoDB数据库?PyMongo常见语法

Python是目前比较流行的程序设计语言,特别是在人工智能和大数据分析处理上,市场空间是比较大的。写此同时,MongDB是比较流行的NoSQL数据库的解决方案,两者结合使用的场景非常多。 查看全文>>

Python+大数据技术文章2021-06-08 |传智教育 |Python如何连连接MongoDB数据库

-

ETL常见工具介绍:Pantlo Kertle、Howk、lormi PowerCene及DataStage

目前比较流行的ETL工具有Pantlo Kertle、Howk、lormi PowerCene及DataStage,对这些工具的介绍如下。 查看全文>>

Python+大数据技术文章2021-06-08 |传智教育 |Pantlo Kertle、Howk、lormi PowerCene及DataStage

-

ETL的全量加载、增量加载以及批量加载

数据的加载是ETL的最后一个阶段,它的主要任务是将数据从临时数据表或文件中加载到指定的数据仓库中。-般来说,可以通过编写sQL语句和利用加载工具将数据加载到数据仓库中。ETL的数据加载和数据抽取类似,将数据加载到目标数据表或者数据仓库的过程中可分为全量加载、增量加载以及批量加载。下面详细介绍一下ETL的全量加载、增量加载以及批量加载。 查看全文>>

Python+大数据技术文章2021-06-08 |传智教育 |ETL的全量加载、增量加载以及批量加载

-

ETL如何进行数据的清洗转换?

数据的清洗转换是指将抽取到的数据源表中的数据,根据数据仓库系统模型的要求进行数据的清洗、转换等操作,保证来自不同系统、不同格式数据的一致性和完整性,并且要按照业务要求加载到目标表。数据的清洗转换是ETL中最复杂的部分,主要任务是过滤掉不符合要求的数据。不符合要求的数据主要是有不完整的数据、错误的数据、重复的数据三大类。下面针对不符合要求的三大类数据进行详细介绍。 查看全文>>

Python+大数据技术文章2021-06-08 |传智教育 |数据的清洗转换

-

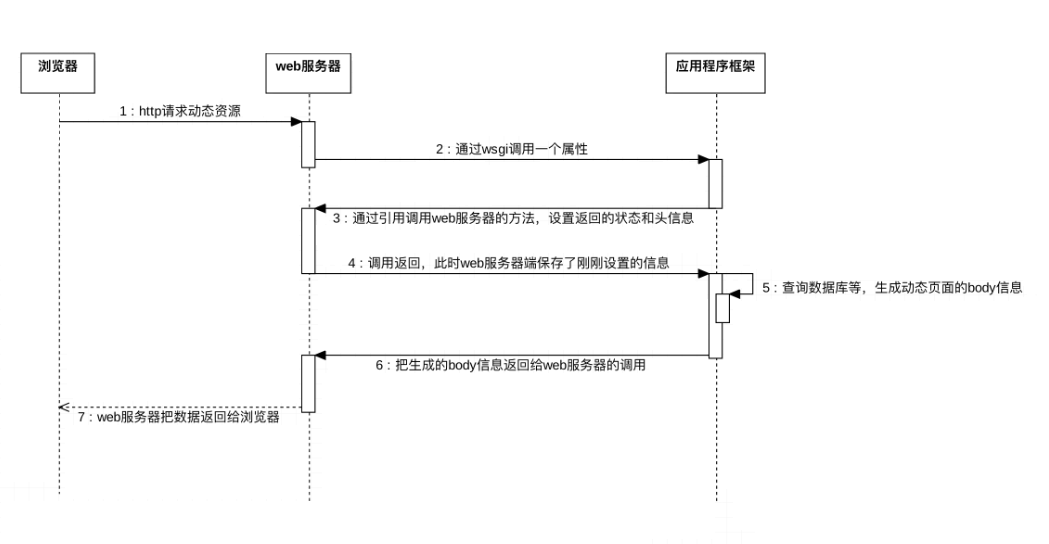

浏览器可以通过WSGI请求动态资源吗?具体怎样操作?

浏览器通过 WSGI 请求动态资源的过程可分为以下7个步骤: 查看全文>>

Python+大数据技术文章2021-06-04 |传智教育 |浏览器通过WSGI请求动态资源的过程

-

AI智能应用开发

AI智能应用开发 AI大模型开发(Python)

AI大模型开发(Python) AI鸿蒙开发

AI鸿蒙开发 AI嵌入式+机器人开发

AI嵌入式+机器人开发 AI运维

AI运维 AI测试

AI测试 跨境电商运营

跨境电商运营 AI设计

AI设计 AI视频创作与直播运营

AI视频创作与直播运营 微短剧拍摄剪辑

微短剧拍摄剪辑 C/C++

C/C++ 狂野架构师

狂野架构师